Трансформеры wiki: Недопустимое название | Transformers вики

Transformers Wiki Guide — IGN

Transformers Wiki Guide

Автор: IGN-GameGuides, IGN-Cheats, +19 more

обновлено

Добро пожаловать в вики-руководство по Трансформерам.

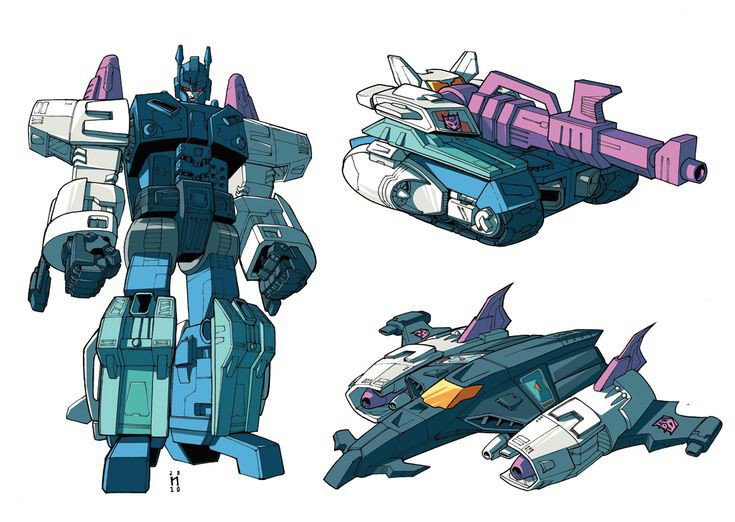

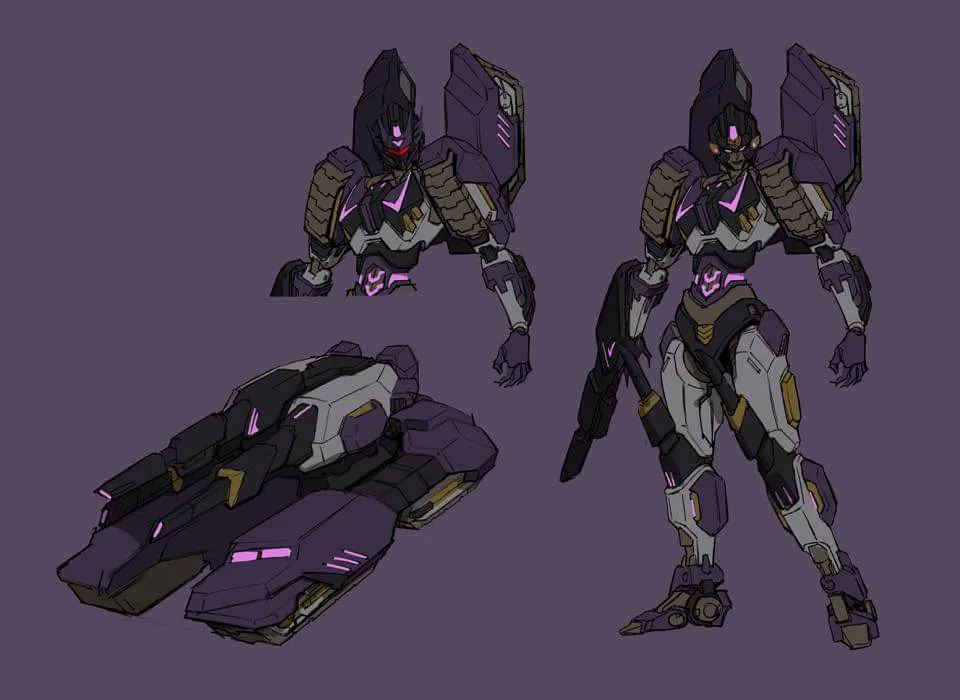

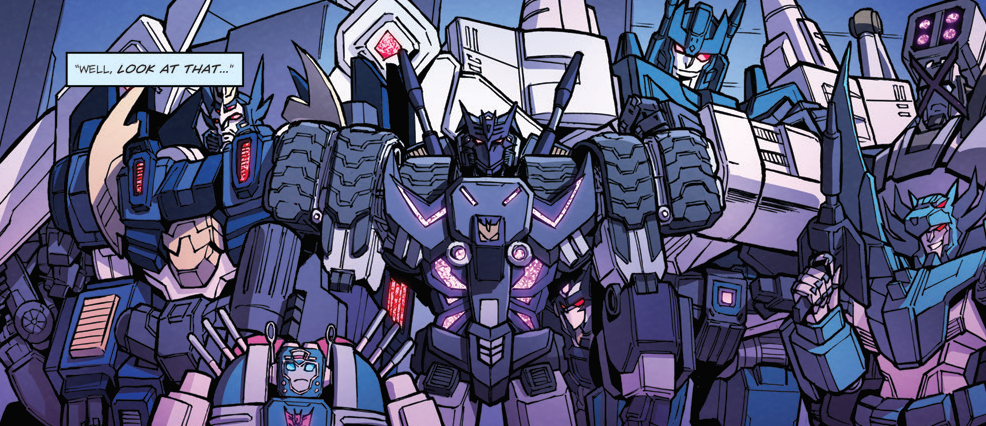

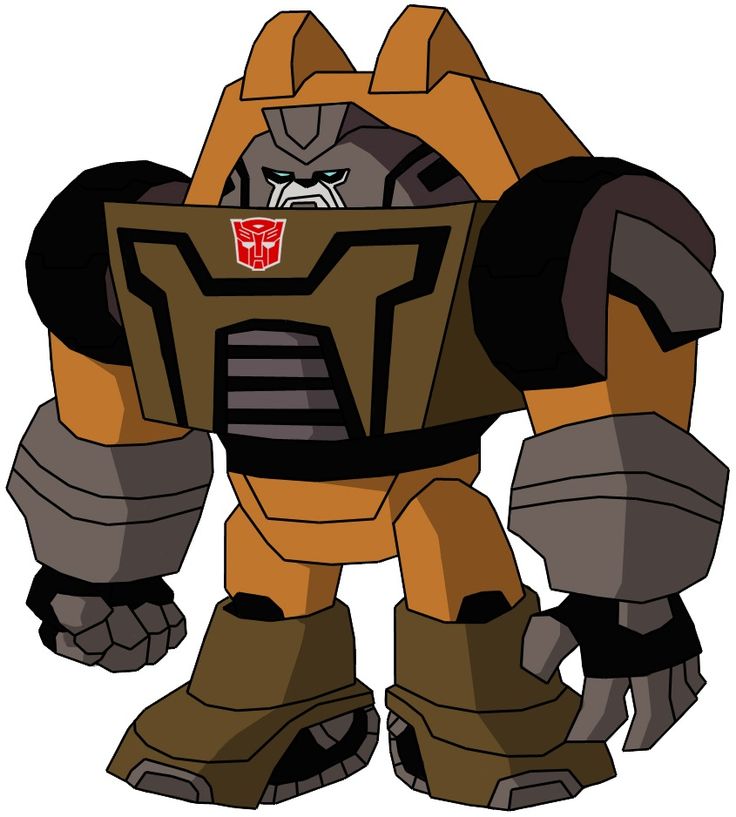

Бесчисленное количество тысячелетий автоботы и десептиконы вели войну против Земли. Оптимус Прайм и компания должны уничтожить Мегатрона и его бесконечную армию десептиконов, а вы у их руля.

реклама

Как настоящий убийца десептиконов, Transformers — это нечто большее, чем кажется на первый взгляд. С семью гигантскими средами, усеянными сорока Mini-Cons для увеличения вашей силы Autobot, и пятьдесят восемью элементами Data-Con, разбросанными повсюду, Transformers имеет достаточно проблем, чтобы расстроить даже таких, как Оптимус Прайм. В IGN мы раскрыли все Mini-Cons и Data-Cons, покорили все огромные уровни и победили всех боссов десептиконов. Хочешь быть крутым автоботом, как мы? Мы здесь, чтобы помочь вам достичь нашего уровня славы Кибертрона с помощью:

Основы автоботов. Чтобы достичь вершины в карьере автоботов, нужно начать с самых низов — общие советы, которые помогут вам встать на ноги.

Чтобы достичь вершины в карьере автоботов, нужно начать с самых низов — общие советы, которые помогут вам встать на ноги.

Battle Tactics: Сражаться с армиями в одиночку — это не прогулка в парке. Наши боевые стратегии превратят любую слабость в вашей защите в силу в нападении.

Десептиклоны: узнайте своих врагов с нашими описаниями их сильных… и слабых сторон.

Прохождение: Все уровни взломаны — найдите всех Мини-Конов и Дата-Конов и полностью уничтожьте боссов Десептиконов!

Секреты: множество читов, которые помогут любому автоботу-бездельнику. Ты знаешь кто ты есть.

Эта вики была автоматически преобразована из руководства Transformers Guide (PS2) по адресу https://guides.ign.com/guides/567186/ и может потребовать очистки. Пожалуйста, помогите улучшить эту вики, если можете, и удалите это уведомление, если это уместно.

Помощь участникам

Если вы не знакомы с редактированием наших вики, это простое практическое руководство покажет вам, как начать работу.

- Introduction

- Autobot Basics

- Battle Tactics

- Upper Tier Combat Units

- Starscream Revisited

- Pacific Island

- Mini-Cons

- Secrets

- Walkthrough

- Mid-Atlantic

Up Next: Introduction

Предыдущий

Читы для PS2

Следующий

Введение

Было ли это руководство полезным?

В этом путеводителе по вики

Трансформеры

Melbourne House

Рейтинг

ESRB: TeenПлатформы

PlayStation 2Deate of MyStical Ninja

333333333333333333.

В «Наследии Хогвартса» есть много типов замков, которые будут блокировать ваш путь, когда вы стремитесь исследовать глубины Хогвартса, а также доступ к определенным зданиям в сундуках, которые также можно найти в деревне Хогсмид и нагорьях. Изучая открывающее заклинание Алохомора от садовника, мистера Муна, вы узнаете о Статуях Демимаски – небольших статуях существ, держащих в руках светящиеся луны, которые можно получить, только когда они мерцают ночью. Мун научит вас более мощным версиям Алохоморы, чтобы разблокировать замки уровня 2 и уровня 3. Итак, чтобы помочь вам улучшить свои навыки взлома, в этом видео подробно рассказывается о местонахождении всех статуй Демигиза, которые вы можете найти во всех регионах Наследия Хогвартса.

Изучая открывающее заклинание Алохомора от садовника, мистера Муна, вы узнаете о Статуях Демимаски – небольших статуях существ, держащих в руках светящиеся луны, которые можно получить, только когда они мерцают ночью. Мун научит вас более мощным версиям Алохоморы, чтобы разблокировать замки уровня 2 и уровня 3. Итак, чтобы помочь вам улучшить свои навыки взлома, в этом видео подробно рассказывается о местонахождении всех статуй Демигиза, которые вы можете найти во всех регионах Наследия Хогвартса.

Разборка лучших спортивных видеоигр по версии IGN: формирование рейтинга

The Legend of Zelda: Tears of the Kingdom — официальная демонстрация игрового процесса

Присоединяйтесь к продюсеру сериала Эйдзи Аонуме, чтобы взглянуть на игровой процесс The Legend of Zelda: Tears of the Kingdom , включая новые способности Линка. В видео также показано, что OLED-модель Nintendo Switch The Legend of Zelda: Tears of the Kingdom Edition будет доступна 28 апреля 2023 года с контроллером Nintendo Switch Pro — The Legend of Zelda: Tears of the Kingdom edition и футляром для переноски Nintendo Switch. – Издание Legend of Zelda: Tears of the Kingdom доступно 12 мая 2023 г. The Legend of Zelda: Tears of the Kingdom будет доступно на Nintendo Switch 12 мая 2023 г.

– Издание Legend of Zelda: Tears of the Kingdom доступно 12 мая 2023 г. The Legend of Zelda: Tears of the Kingdom будет доступно на Nintendo Switch 12 мая 2023 г.

Как работают трансформаторы. Трансформеры — это тип нейронных… | от Giuliano Giacaglia

Нейронная сеть, используемая Open AI и DeepMind

Если вам понравился этот пост и вы хотите узнать, как работают алгоритмы машинного обучения, как они возникли и куда они идут, я рекомендую следующее:

Заставить вещи думать: как ИИ и глубокое обучение улучшают продукты, которые мы используем – Холлоуэй

Это очевидное, что так трудно увидеть большую часть времени. Люди говорят: «Это так же очевидно, как нос на твоем лице»…

www.holloway.com

Трансформеры — это набирающий популярность тип архитектуры нейронной сети. Трансформеры недавно использовались OpenAI в своих языковых моделях, а также недавно использовались DeepMind для AlphaStar — их программы для победы над лучшим профессиональным игроком в Starcraft.

Преобразователи были разработаны для решения проблемы преобразования последовательности , или нейронного машинного перевода. Это означает любую задачу, которая преобразует входную последовательность в выходную последовательность. Это включает в себя распознавание речи, преобразование текста в речь и т. д.

Трансдукция последовательности. Вход представлен зеленым цветом, модель представлена синим цветом, а выход представлен фиолетовым цветом. GIF от 3Чтобы модели выполняли преобразование последовательности , необходимо иметь какую-то память. Например, предположим, что мы переводим следующее предложение на другой язык (французский):

«Трансформеры» — японская [[хардкор-панк]] группа. Группа была образована в 1968 году, на пике истории японской музыки»9.0005

В этом примере слово «группа» во втором предложении относится к группе «Трансформеры», представленной в первом предложении. Когда вы читаете о группе во втором предложении, вы знаете, что это относится к группе «Трансформеры». Это может быть важно для перевода. Есть много примеров, когда слова в некоторых предложениях относятся к словам в предыдущих предложениях.

Когда вы читаете о группе во втором предложении, вы знаете, что это относится к группе «Трансформеры». Это может быть важно для перевода. Есть много примеров, когда слова в некоторых предложениях относятся к словам в предыдущих предложениях.

Для перевода таких предложений модель должна определить такого рода зависимости и связи. Рекуррентные нейронные сети (RNN) и сверточные нейронные сети (CNN) использовались для решения этой проблемы из-за их свойств. Давайте рассмотрим эти две архитектуры и их недостатки.

Рекуррентные нейронные сети содержат циклы, позволяющие сохранять информацию.

Вход представлен как x_tНа рисунке выше мы видим часть нейронной сети, A, , обрабатывающую некоторые входные данные x_t и выходные данные h_t. Цикл позволяет передавать информацию от одного шага к другому.

Циклы можно представить по-разному. Рекуррентную нейронную сеть можно рассматривать как несколько копий одной и той же сети, A , каждая сеть передает сообщение преемнику. Рассмотрим, что произойдет, если мы развернём цикл:

Рассмотрим, что произойдет, если мы развернём цикл:

Эта цепочечная природа показывает, что рекуррентные нейронные сети явно связаны с последовательностями и списками. Таким образом, если мы хотим перевести какой-то текст, мы можем установить каждый ввод как слово в этом тексте. Рекуррентная нейронная сеть передает информацию о предыдущих словах в следующую сеть, которая может использовать и обрабатывать эту информацию.

На следующем рисунке показано, как обычно работает модель от последовательности к последовательности с использованием рекуррентных нейронных сетей. Каждое слово обрабатывается отдельно, и результирующее предложение генерируется путем передачи скрытого состояния на этап декодирования, который затем генерирует выходные данные.

GIF from 3Проблема долговременных зависимостей

Рассмотрим языковую модель, пытающуюся предсказать следующее слово на основе предыдущих. Если мы пытаемся предсказать следующее слово предложения «облака в небе» , нам не нужен дополнительный контекст. Совершенно очевидно, что следующим словом будет небо.

Совершенно очевидно, что следующим словом будет небо.

В этом случае, когда разница между релевантной информацией и местом, которое необходимо, невелика, RNN могут научиться использовать прошлую информацию и выяснить, какое следующее слово для этого предложения.

Изображение из 6Но бывают случаи, когда нам нужно больше контекста. Например, предположим, что вы пытаетесь предсказать последнее слово текста: «Я вырос во Франции… Я свободно говорю…». Недавняя информация предполагает, что следующее слово, вероятно, является языком, но если мы хотим сузить выбор языка, нам нужен контекст Франции, который находится дальше по тексту.

Изображение из 6RNN становится очень неэффективным, когда разрыв между релевантной информацией и точкой, где она необходима, становится очень большим. Это связано с тем, что информация передается на каждом шагу, и чем длиннее цепочка, тем больше вероятность потери информации по цепочке.

Теоретически RNN могут изучить эти долгосрочные зависимости. На практике кажется, что они их не учат. LSTM, особый тип RNN, пытается решить эту проблему.

На практике кажется, что они их не учат. LSTM, особый тип RNN, пытается решить эту проблему.

При составлении календаря на день мы расставляем приоритеты в наших встречах. Если есть что-то важное, мы можем отменить некоторые встречи и договориться о том, что важно.

РНС так не делают. Всякий раз, когда он добавляет новую информацию, он полностью преобразует существующую информацию, применяя функцию. Вся информация модифицируется, и нет рассмотрения того, что важно, а что нет.

LSTM вносят небольшие изменения в информацию путем умножения и добавления. В LSTM информация проходит через механизм, известный как состояния ячеек. Таким образом, LSTM могут выборочно запоминать или забывать важные и не очень важные вещи.

Внутренне LSTM выглядит следующим образом:

Изображение из 6 Каждая ячейка принимает в качестве входных данных x_t (слово в случае перевода предложения в предложение), предыдущее состояние ячейки и вывод предыдущей ячейки . Он манипулирует этими входными данными и на их основе генерирует новое состояние ячейки и выходные данные. Я не буду вдаваться в детали механики каждой ячейки. Если вы хотите понять, как работает каждая ячейка, я рекомендую запись в блоге Кристофера:

Он манипулирует этими входными данными и на их основе генерирует новое состояние ячейки и выходные данные. Я не буду вдаваться в детали механики каждой ячейки. Если вы хотите понять, как работает каждая ячейка, я рекомендую запись в блоге Кристофера:

Понимание сетей LSTM — блог Колы

Из-за этих циклов рекуррентные нейронные сети кажутся загадочными. Однако, если еще немного подумать, оказывается, что…

colah.github.io

В состоянии ячейки информация в предложении, важная для перевода слова, может передаваться от одного слова к другому при переводе.

Проблема с LSTM

Та же проблема, которая обычно возникает с RNN, возникает и с LSTM, т. е. когда предложения слишком длинные, LSTM по-прежнему не слишком хороши. Причина этого в том, что вероятность сохранения контекста слова, находящегося далеко от текущего обрабатываемого слова, экспоненциально уменьшается с удалением от него.

Это означает, что при длинных предложениях модель часто забывает содержание удаленных позиций в последовательности. Другая проблема с RNN и LSTM заключается в том, что трудно распараллелить работу по обработке предложений, поскольку вам приходится обрабатывать слово за словом. Не только это, но и отсутствие модели долгосрочных и краткосрочных зависимостей. Подводя итог, LSTM и RNN представляют 3 проблемы:

Другая проблема с RNN и LSTM заключается в том, что трудно распараллелить работу по обработке предложений, поскольку вам приходится обрабатывать слово за словом. Не только это, но и отсутствие модели долгосрочных и краткосрочных зависимостей. Подводя итог, LSTM и RNN представляют 3 проблемы:

- Последовательные вычисления препятствуют распараллеливанию

- Отсутствие явного моделирования длинных и коротких зависимостей

- «Расстояние» между позициями линейно

Чтобы решить некоторые из этих проблем, исследователи создали технику, позволяющую обращать внимание на определенные слова.

При переводе предложения я уделяю особое внимание слову, которое сейчас перевожу. Когда я расшифровываю аудиозапись, я внимательно слушаю фрагмент, который активно записываю. И если вы попросите меня описать комнату, в которой я сижу, я буду оглядываться на объекты, которые описываю.

Нейронные сети могут добиться такого же поведения, используя внимание , фокусируясь на части подмножества информации, которую они получают. Например, RNN может следить за выходом другой RNN. На каждом временном шаге он фокусируется на разных позициях в другой RNN.

Например, RNN может следить за выходом другой RNN. На каждом временном шаге он фокусируется на разных позициях в другой RNN.

Чтобы решить эти проблемы, Внимание — это метод, который используется в нейронной сети. Для RNN вместо того, чтобы просто кодировать все предложение в скрытом состоянии, каждое слово имеет соответствующее скрытое состояние, которое передается на всем пути к этапу декодирования. Затем скрытые состояния используются на каждом этапе RNN для декодирования. Следующий gif показывает, как это происходит.

Шаг зеленого цвета называется этапом кодирования , а этап фиолетового цвета — этапом декодирования . GIF от 3Идея заключается в том, что в каждом слове предложения может быть важная информация. Таким образом, чтобы декодирование было точным, оно должно учитывать каждое слово ввода, используя внимания.

Чтобы привлечь внимание к RNN в трансдукции последовательности, мы разделяем кодирование и декодирование на 2 основных этапа. Один шаг представлен в зеленый и другой фиолетовый . Шаг зеленого цвета называется этапом кодирования , а этап фиолетового цвета — этапом декодирования .

Один шаг представлен в зеленый и другой фиолетовый . Шаг зеленого цвета называется этапом кодирования , а этап фиолетового цвета — этапом декодирования .

Зеленый шаг, отвечающий за создание скрытых состояний из ввода. Вместо того, чтобы передавать декодерам только одно скрытое состояние, как мы делали до использования внимание , мы передаем все скрытые состояния, генерируемые каждым «словом» предложения, на этап декодирования. Каждое скрытое состояние используется в декодировании этап , чтобы выяснить, на что сеть должна обратить внимание .

Например, при переводе предложения « Je suis étudiant» на английский требуется, чтобы шаг декодирования рассматривал разные слова при переводе.

Этот gif показывает, какой вес придается каждому скрытому состоянию при переводе предложения «Je suis étudiant» на английский язык. Чем темнее цвет, тем больший вес придается каждому слову. GIF от 3

Чем темнее цвет, тем больший вес придается каждому слову. GIF от 3Или, например, когда вы переводите предложение «L’accord sur la zone économique européenne a été signé en août 1992». с французского на английский, и сколько внимания уделяется каждому вводу.

Перевод предложения «L’accord sur la zone économique européenne a été signé en août 1992». на английский. Изображение из 3Но некоторые из проблем, которые мы обсуждали, до сих пор не решены с помощью RNN, использующих внимание . Например, параллельная обработка входных данных (слов) невозможна. Для большого корпуса текста это увеличивает время, затрачиваемое на перевод текста.

Сверточные нейронные сети помогают решить эти проблемы. С ними мы можем

- Простота параллелизации (по слоям)

- Использует локальные зависимости

- Расстояние между позициями логарифмическое

Некоторые из самых популярных нейронных сетей для преобразования последовательностей, Wavenet и Bytenet, представляют собой сверточные нейронные сети.

Причина, по которой сверточные нейронные сети могут работать параллельно, заключается в том, что каждое слово на входе может обрабатываться одновременно и не обязательно зависит от предыдущих переводимых слов. Мало того, «расстояние» между выходным словом и любым входом для CNN составляет порядка log(N) — это размер высоты дерева, сгенерированного от выхода до входа (вы можете видеть это на GIF выше. Это намного лучше, чем расстояние между выходом RNN и входом , что порядка N .

Проблема в том, что Сверточные Нейронные Сети не обязательно помогают с проблемой выяснения проблемы зависимостей при переводе предложений. сочетание обоих CNN с вниманием.

Чтобы решить проблему распараллеливания, Transformers пытаются решить эту проблему, используя сверточные нейронные сети вместе с моделями внимания . Внимание повышает скорость перевода модели из одной последовательности в другую.

Давайте посмотрим, как работает Трансформатор . Трансформер — это модель, которая использует внимание для увеличения скорости. В частности, он использует 90 118 внимания к себе.

Трансформер. Изображение с 4Внутри Transformer имеет такую же архитектуру, как и предыдущие модели, описанные выше. А вот Transformer состоит из шести энкодеров и шести декодеров.

Изображение из 4Каждый энкодер очень похож друг на друга. Все кодировщики имеют одинаковую архитектуру. Декодеры имеют одно и то же свойство, то есть они также очень похожи друг на друга. Каждый кодировщик состоит из двух слоев: Самостоятельное внимание и нейронная сеть прямой передачи.

Изображение из 4 Входы энкодера сначала проходят через уровень внимания . Это помогает кодировщику смотреть на другие слова во входном предложении, поскольку он кодирует конкретное слово. У декодера есть оба этих слоя, но между ними находится слой внимания, который помогает декодеру сосредоточиться на соответствующих частях входного предложения.

Примечание: Этот раздел взят из сообщения в блоге Джея Алламара

Давайте начнем рассматривать различные векторы/тензоры и то, как они перетекают между этими компонентами, чтобы превратить ввод обученной модели в вывод. Как и в случае с приложениями НЛП в целом, мы начинаем с преобразования каждого входного слова в вектор с помощью алгоритма встраивания.

Изображение взято из 4Каждое слово встроено в вектор размером 512. Мы будем представлять эти векторы с помощью этих простых прямоугольников.

Встраивание происходит только в самом нижнем кодировщике. Абстракция, общая для всех кодировщиков, заключается в том, что они получают список векторов, каждый из которых имеет размер 512.

прямо внизу. После встраивания слов в нашу входную последовательность каждое из них проходит через каждый из двух слоев кодировщика.

Изображение из 4 Здесь мы начинаем видеть одно ключевое свойство Преобразователя, а именно то, что слово в каждой позиции проходит в кодировщике по своему пути. Между этими путями на уровне внимания к себе существуют зависимости. Однако уровень прямой связи не имеет таких зависимостей, и поэтому различные пути могут выполняться параллельно при прохождении через уровень прямой связи.

Между этими путями на уровне внимания к себе существуют зависимости. Однако уровень прямой связи не имеет таких зависимостей, и поэтому различные пути могут выполняться параллельно при прохождении через уровень прямой связи.

Далее мы переключим пример на более короткое предложение и посмотрим, что происходит на каждом подуровне кодировщика.

Само-внимание

Давайте сначала посмотрим, как рассчитать само-внимание с помощью векторов, а затем перейдем к тому, как это на самом деле реализуется — с помощью матриц.

Выяснение соотношения слов в предложении и уделение ему правильного внимания. Изображение из 8 Первый шаг в вычислении собственного внимания заключается в создании трех векторов из каждого из входных векторов кодировщика (в данном случае встраивания каждого слова). Итак, для каждого слова мы создаем вектор запроса, вектор ключа и вектор значения. Эти векторы создаются путем умножения вложения на три матрицы, которые мы обучали в процессе обучения.

Обратите внимание, что эти новые векторы меньше по размеру, чем вектор вложения. Их размерность равна 64, в то время как векторы ввода/вывода встраивания и кодирования имеют размерность 512. Они НЕ ДОЛЖНЫ быть меньше, это выбор архитектуры, чтобы сделать вычисление многоголового внимания (в основном) постоянным.

Изображение взято из 4Умножение x1 на весовую матрицу WQ дает q1, вектор «запроса», связанный с этим словом. В итоге мы создаем «запрос», «ключ» и «значение» проекции каждого слова во входном предложении.

Что такое векторы «запрос», «ключ» и «значение»?

Это абстракции, полезные для расчета внимания и размышлений о нем. Как только вы продолжите читать ниже, как рассчитывается внимание, вы узнаете почти все, что вам нужно знать о роли, которую играет каждый из этих векторов.

Второй шаг в подсчете внимания к самому себе заключается в подсчете балла. Скажем, мы вычисляем само-внимание для первого слова в этом примере «Думаю». Нам нужно сопоставить каждое слово входного предложения с этим словом. Оценка определяет, сколько внимания нужно уделять другим частям входного предложения, когда мы кодируем слово в определенной позиции.

Нам нужно сопоставить каждое слово входного предложения с этим словом. Оценка определяет, сколько внимания нужно уделять другим частям входного предложения, когда мы кодируем слово в определенной позиции.

Оценка рассчитывается путем скалярного произведения вектора запроса на ключевой вектор соответствующего слова, которое мы оцениваем. Итак, если мы обрабатываем самовнимание для слова в позиции № 1, первая оценка будет скалярным произведением q1 и k1. Вторая оценка будет скалярным произведением q1 и k2.

Image from 4третий и четвертый шаги заключаются в делении баллов на 8 (квадратный корень из размерности ключевых векторов, использованных в статье — 64. Это приводит к более стабильным градиентам. Могут быть и другие возможные значения здесь, но это значение по умолчанию), затем передайте результат через операцию softmax. Softmax нормализует оценки, чтобы все они были положительными и в сумме составляли 1,9.0005 Изображение из 4

Этот показатель softmax определяет, насколько сильно каждое слово будет выражено в этой позиции. Очевидно, что слово в этой позиции будет иметь наивысший балл softmax, но иногда полезно обратить внимание на другое слово, имеющее отношение к текущему слову.

Очевидно, что слово в этой позиции будет иметь наивысший балл softmax, но иногда полезно обратить внимание на другое слово, имеющее отношение к текущему слову.

Пятый шаг заключается в умножении каждого вектора значений на оценку softmax (при подготовке к их суммированию). Интуиция здесь состоит в том, чтобы сохранить нетронутыми значения слов, на которых мы хотим сосредоточиться, и заглушить нерелевантные слова (например, умножив их на крошечные числа, такие как 0,001).

Шестой шаг заключается в суммировании взвешенных векторов значений. Это производит вывод слоя внутреннего внимания в этой позиции (для первого слова).

Изображение из 4 На этом расчет собственного внимания завершен. Результирующий вектор — это тот, который мы можем отправить в нейронную сеть с прямой связью. Однако в реальной реализации этот расчет выполняется в матричной форме для более быстрой обработки. Итак, давайте посмотрим на это теперь, когда мы увидели интуицию расчета на уровне слов.

Мультиголовное внимание

Трансформеры в основном работают так. Есть еще несколько деталей, которые улучшают их работу. Например, вместо того, чтобы обращать внимание друг на друга только в одном измерении, Трансформеры используют концепцию многоголового внимания.

Идея заключается в том, что всякий раз, когда вы переводите слово, вы можете уделять различное внимание каждому слову в зависимости от типа вопроса, который вы задаете. Изображения ниже показывают, что это означает. Например, всякий раз, когда вы переводите «ударил ногой» в предложении «Я ударил по мячу», вы можете спросить «Кто ударил». В зависимости от ответа перевод слова на другой язык может измениться. Или задайте другие вопросы, например «Что сделал?» и т. д.

Изображения из 8Позиционное кодирование

Другим важным шагом в Transformer является добавление позиционного кодирования при кодировании каждого слова. Кодирование положения каждого слова имеет значение, поскольку положение каждого слова имеет отношение к переводу.