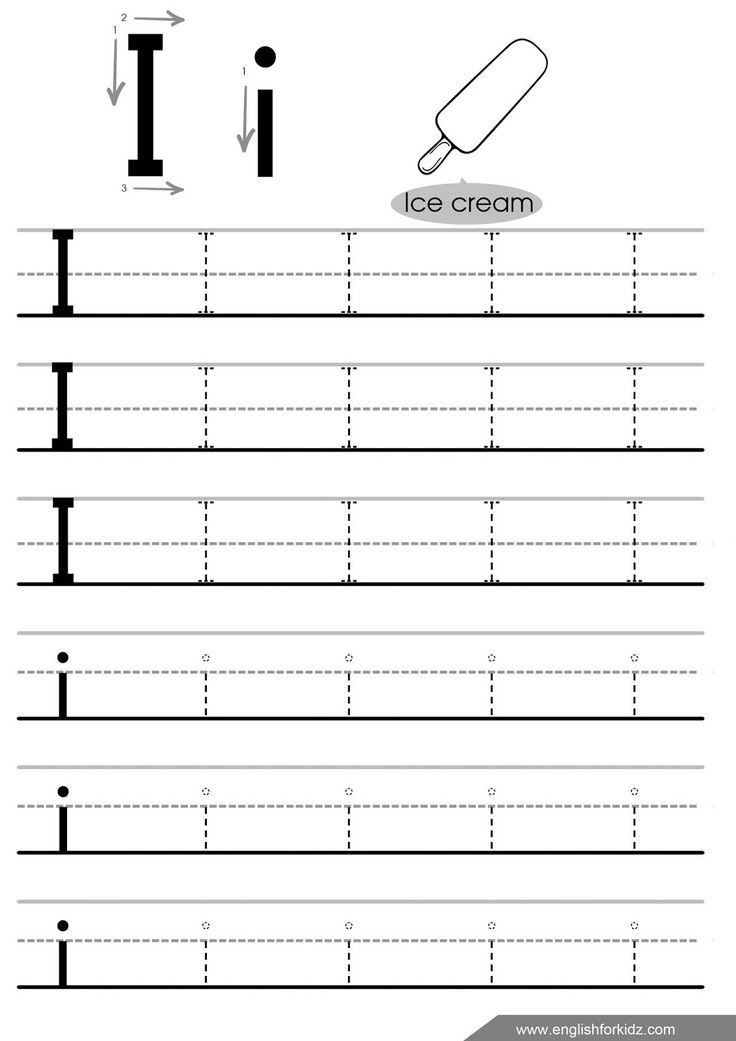

Английская буква ай: Буква I английского алфавита

Английские сокращения и названия из сферы IT, которые мы неправильно произносим / Хабр

Предыдущая статья на тему произношения английских слов получила много позитивных откликов, поэтому я решил продолжить эту тему и рассказать про сокращения и имена собственные.

По возможности к каждому слову я буду прилагать IPA транскрипцию для US English, русскую «упрощенную» транскрипцию и ссылку на видео, в котором можно услышать, как это слово произносят носители.

В случаях, когда произношение очевидно из пояснения, IPA транскрипция или видео могут быть пропущены. И перед тем, как перейти к статье, еще раз хочу сказать, что русская транскрипция — исключительно для ориентира, и споры вроде «визивиг» или «уизиуиг», «амазон» или «эмазан», считаю неуместными.

И чтобы избежать недопониманий — все что указано в статье, касается англоязычной среды и общения на английском языке. В русском и других языках все эти слова могут произноситься так, как сложилось исторически в той или иной среде.

Начнем с сокращений из сферы IT. Бо́льшая их часть произносится по буквам, но есть исключения, которые представляют собой либо акронимы, либо просто исторически имеют более краткое прочтение:

- AFAIK /ə´feik/ (афэ́йк)

- ASAP /ˌeɪ ɛs eɪ ˈpi/, /ˈeɪsæp/ (эй-эс-ей-пи́, эйсэп) — можно встретить оба варианта, но первый более характерен для Британии.

- ASCII /ˈæski/ (а́ски)

- GNU /ɡnuː/ (гну)

- GUI — тут нам повезло, он и в английском варианте произносится как «гу́и».

- ICANN /ˈaɪ kæn/ (ай-кэн)

- ISO /ˈaɪsoʊ/ (а́йсоу) — самое интересное, что это не сокращение по первым буквам, а просто название организации. Больше деталей можно почитать здесь.

- JSON (джейсон) — ударение может быть как на первый, так и на второй слог.

- LINQ — возможны два варианта: «линк» и «линкью́».

- REST — тут все очевидно, это акроним, и читать его как «ар-и-эс-ти» нет никакого смысла.

- SQL /ˈsiːkwəl/, /ˌɛs kjˌuː ˈɛl/ — классика, можно и «сикуэл» и «эс-кью-эл».

От носителей намного чаще слышал первый вариант.

От носителей намного чаще слышал первый вариант. - SOAP /soʊp/ (со́уп) — наш «со́ап» не так далек от истины в этом случае.

- WSDL /ˈwɪz dəl/ (уи́здэл) — привычный нам «вэ-эс-дэ-эль» будет западной аудитории непонятен, «дабл-ю-эс-ди-эл» поймут, но зачем себя так утруждать? К букве «w» в аббревиатурах мы еще чуть позже вернемся.

- WYSIWYG /ˈwɪziwɪɡ/ (уи́зиуиг)

- XAML /ˈzæməl/ (зэ́мэл) — не «ксамл».

- ZIP — независимо от того, речь идет о почтовом коде, архиваторе или расширении файла, он звучит как «зип».

- etc. /ˌɛt ˈsɛtərə/, /ˌɛtˈsɛtrə/, /ɪtˈsɛtərə/, /ɪt ˈsɛtrə/ — любой из «эт-сэ́тера», «эт-сэ́тра», «ит-сэ́тэра», «ит-сэ́тра» будет правильным, так как происходит от латинского «et cetera». Но достаточно часто, причем даже от нэйтивов, можно услышать «эксэтра», что не является нормой.

Также есть ряд сокращений, которые в английском ничем не выделяются среди других, но русскоязычной аудитории на них стоит обратить особое внимание, так как мы привыкли их произносить как нам удобно:

- API — это не «апи», это «эй-пи-ай».

- IO — «ай-оу».

- IE — «ай-и».

- AI — «эй-ай».

- IDE — «ай-ди-и».

- EXE — «и-экс-и́», привычный нам «экзэ» может быть непонятен англоязычным коллегам, несколько раз встречал подобные ситуации.

- AWS — «эй-дабл-ю-эс», никак не «а-вэ-эс».

- JWT — «джей-дабл-ю-ти» или «джот» (второй вариант считается «каноничным» для этого термина), очень часто от коллег слышу неправильный вариант «джи-ви-ти», который будет понят нэйтивами как «GVT».

В приведенных выше примерах несложно заметить, что для русскоязычной среды характерно ошибочное произношение английских букв, даже если речь идет об употреблении сокращений в английской речи. Рассмотрим наиболее проблемные буквы:

- A — это «эй», и если вы на нее говорите «а», носитель английского может это понять как «R».

- R — обратная ситуация, буквы «эр» в английском алфавите нет, а вместо нее есть «а» или «ар» (в зависимости от сложившегося на той или иной территории произношения).

- E — буквы «е» в английском алфавите тоже нет, правильно ее произносить как «и». Соответственно всякие «емэйл» и «ие» тоже звучат чуждо для англоязычного уха.

- H — «эйч», пусть наш «аш-ти-эм-эль» более-менее понятен и узнаваем, но лучше ту же аббревиатуру произносить как «эйч-ти-эм-эл».

- J — это «джей». Самое интересное, что в плане чтения по буквам проблем с G (которая «джи») я не припомню, а вот J почему-то многие читают как «джи» или даже «йот».

- K — «кэй»

- W — самая проблемная буква. Из-за нехарактерной для русского языка длины её «имени», мы пытаемся сократить прочтение до «вэ» или «ви», и делаем это совершенно напрасно. Эту букву следует читать как «дабл-ю».

- X — «экс», не «икс».

- Y — «уай», не «игрек».

- Z — тут ситуация интересная — британцы и американцы ее произносят по-разному. Насколько я замечаю, мы привыкли к британскому варианту «зэд», но в Северной Америке принято называть эту букву «зи».

Поэтому DMZ в США будут чаще произносить как «ди-эм-зи».

Поэтому DMZ в США будут чаще произносить как «ди-эм-зи».

Есть еще категория сокращений, которую хотелось бы рассмотреть отдельно — те, где есть несколько одинаковых букв подряд. С ними тоже не всегда наблюдается закономерность:

- IaaS, PaaS, SaaS — тут я слышал два варианта от нэйтивов: либо произнесение каждой буквы («ай-эй-эй-эс», «пи-эй-эй-эс», «эс-эй-эй-эс»), либо произнесение двух «а» как одного длинного звука («айээс», «пээс», «сээс», или то же самое, но с длинным звуком «а» в середине).

- IEEE — в данном случае три буквы подряд читаются как «трипл-и», т.е. вся аббревиатура читается как «ай-трипл-и».

- DDD — просто «ди-ди-ди».

- WWW — в общем случае это «дабл-ю-дабл-ю-дабл-ю», но в зависимости от региона можно встретить сокращения виде «даб-ю-даб-ю-даб-ю» или даже «даб-даб-даб».

Перейдем к именам собственным, и в первую очередь рассмотрим «проблемные» названия компаний.

- Amazon /ˈæməz(ə)n/ (э́мазан) — ударение на первом слоге.

- Verizon /vəˈraɪz(ə)n/ (вэра́йзн) — эта и предыдущая в списке компании имеют одинаковые окончания в названии, но разное прочтение буквы перед окончанием. Некоторым хочется на первый сказать «амэйзн», а на второй — «веризон», но это будет неверно.

- Adobe /əˈdoʊbi/ — хоть мы и привыкли читать его как «адоб», «на родине» эту компанию называют «адо́уби» или «адо́би».

- Nike /ˈnaɪki/ (на́йки) — пусть и не IT-компания, но я не смог пройти мимо. Последнюю букву здесь, как и в случае с Adobe, нужно произносить.

- ASUS (э́й-сус)

- EPAM (ипэ́м) — помним, что первая буква этого названия в английском алфавите звучит как «и» 😉

- Cisco — вспоминаем, что звука «ц» в английском нет, вспоминаем, как читается San-Francisco и говорим «си́скоу».

- Logitech — вариантов прочтения этого бренда в наших краях я слышал немало – «логитек», «логитеч», «лоджитеч», но правильный — «ло́джитек».

- McAfee (мэ́кафи)

- ZyXel — везде указано, что правильное произношение «за́й-сэл», хотя в некоторых видео от самой компании можно услышать и «за́й-зэл», и «за́й-ксэл». Даже песня на эту тему есть. И еще можно встретить видео, где случайных прохожих просят прочитать это название.

А теперь настала очередь программных продуктов и некоторых других имен собственных, которые можно встретить в IT.

- Azure /ˈæʒər/ (э́жур) — как часто бывает с именами собственными, не все носители языка их называют одинаково правильно. «Правильно» в данном случае — то, как владелец бренда считает нужным. Несколько раз слышал от американских коллег неправильный вариант «азю́р», но пониманию это, конечно же, не мешало. И это при том, что слово в английском языке существует и произносится так, как я написал в транскрипции.

- Apache /əˈpætʃi/ (апа́чи) — как и в случае с Adobe и Nike, последнюю букву читать надо.

- Chrome /kroʊm/ (кроум) — как я уже писал в предыдущей статье, «ch» очень редко произносится как «х».

- Excel /ɪkˈsɛl/ (иксэ́л) — ударение на последний слог, а наш «э́ксель» могут с первого раза и не понять.

- Git (гит) — не раз слышал, как русскоязычные коллеги называют его «джит», но это неверно. В IT есть другой термин, который звучит как «джит» — JIT, но отношения к системе контроля версий он не имеет.

- GNOME (гно́ум) — несмотря на то, что в сочетании букв «gn» первая обычно не читается, тут «г» произносить нужно. В первую очередь из-за того, что это — акроним.

- Kubernetes (кубернэ́тис) — в сравнении с тем, как его у нас обычно произносят, отличается в основном последняя гласная.

- Nginx (э́нджин-экс)

- NuGet (ню́гет) — не «нагет».

- OAuth3 (о-а́с ту, о-о́с ту) — здесь на месте «с» — звук θ, которого в русском нет — как в слове «think».

- Redux (ри́дакс) — даже несмотря на то, что это слово в английском есть и имеет ударение на другой слог.

- Ruby (ру́би) — не «раби».

- PostgreSQL /ˈpoʊstɡrɛs ˌkjuː ˈɛl/ (поустгрэс-кью-эл) — по ссылке можно услышать, что его произносят как попало, а не так, как было задумано авторами.

Главное, что все равно понятно, о чем идет речь.

Главное, что все равно понятно, о чем идет речь. - Python /ˈpaɪθɑn/ (па́йcан) — не забываем о звуке θ.

- Qt /kjut/ — не «кью-ти», произносится точно так же, как слово «cute».

- Service Fabric (сёрвис фэ́брик) — русскоязычные коллеги во втором слове упорно делают ударение на последний слог.

К прошлой статье было немало комментариев с обсуждением произношения марок автомобилей. И хоть к IT это напрямую не относится, я включу в эту статью «бонусом» несколько примеров названий, которые в английском произношении заметно отличаются от привычного нам (но это не значит, что они так же звучат на языке оригинала):

- BMW — ну вы поняли, правила для сокращений упомянуты выше в статье. Это «би-эм-дабл-ю», без вариантов.

- Hyundai — имеет массу вариантов произношения в английском, даже не вижу смысла все расписывать. В США чаще всего встречал «ха́ндэй».

- Mercedes /mərˈseɪ diz/ (мёрсэ́йдиз)

- Subaru (су́бару) — ударение на первый слог, как и в «оригинальном» японском варианте.

Списки слов можно продолжать еще долго, особенно если обращать внимание на более экзотические имена и сокращения, но я остановлюсь здесь. Если пропустил что-то важное — пишите. А в следующей статье на тему английского я попытаюсь собрать самые популярные грубые ошибки перевода и грамматики, которые можно услышать от русскоязычных коллег.

Английская транскрипция.

Транскрипция – это специальные символы, обозначающие реально произносимые звуки речи. Необходимость овладения транскрипцией обусловлена расхождением между написанием и произношением в английском языке. Существует большое количество слов, имеющих либо не читаемые буквы, либо исключения из правил. В английской произносительной системе – 48 звуков, следовательно, существует 48 транскрипционных значков. Вы можете слушать голосовое произношение звуков обозначаемых знаками транскрипции Звуковая транскрипция

| Буква | Обозначение в транскрипции | Звуки | Пример |

|---|---|---|---|

| English transcription my-en.ru Updated: 25.02.2018 | |||

| Aa(эй ) | [ei] | Похож на русский звук (эй) | page – [peɪdʒ] – (пэйдж) – страница |

| [æ] | Средний звук между (э) и (а) | bank – [bæŋk] – (бэннк) – банк | |

| [ɑː] | Похож на долгий русский (а) | car – [kɑː] – (каː) – легковой автомобиль | |

| [ɔː] | Долгий звук (о) | hall – [hɔːl] – (хоːл) – зал, холл | |

| Bb(биː) | [b] | Примерно как русский звук (б) | bed – [bed] – (бэд) – кровать, постель |

| Cc(сиː) | [k] | похож на русский звук (к) | camera – [ˈkam(ə)rə] – (ка´мра) – камера, фотокамера |

| [s] | похож на русский звук (с) | bicycle – [ˈbʌɪsɪk(ə)l] – (ба´йсикл) – велосипед | |

| [ ʃ] | Средний звук между (ш) и (щ). | ocean – [ˈəʊʃ(ə)n] – (о´ушн) – океан | |

| Dd(диː) | [d] | Как (д) | did – [dɪd] – (дид) – делать, выполнять |

| Ee(иː) | [iː] | Долгий звук (и) | she – [ʃi] – (шиː) – она |

| [ɪ] | Похож на русский (и) с небольшим оттенком (ы) и (э), как в слове снаружи | zero – [ˈzɪərəʊ] – (зи´роу) – нуль, ноль, нулевой | |

| [e] | Напоминает звук (е) с оттенком (э) | ten – [ten] – (тэн) – десять | |

| [ɜː] | Похож на звук (ё) в словах мёд, лён. | fern – [fɜːn] – (фëːн) – папоротник | |

| Ff(эф) | [f] | Как (ф). | four – [fɔː] – (фоː) – четыре |

| Gg(джи) | [g] | Похож на русский (г). | got – [ˈɡɒt] – (гот) – получать |

| Hh(эйч) | [h] | Короткий выдох (х). | how – [ˈhaʊ] – (хáу) – как, каким образом |

| Ii(ай) | [ai] | Похож на русский звук (ай) | five – [faɪv] – (файв) – пять |

| [ɪ] | Похож на русский (и) с небольшим оттенком (ы) и (э), как в слове снаружи | little – [ˈlɪt(ə)l] – (литл) – маленький | |

| [ɜː] | Похож на звук (ё) в словах мёд, лён. | girl – [ɡɜːl] – (гёːл) – девушка, девочка | |

| [iː] | Долгий звук (и) | machine – [məˈʃiːn] – (мэ´ши´ːн) – машина, механизм | |

| Jj(джей) | [dʒ] | Похож на (дж) | journey – [ˈdʒəːni] – (джëːни) – |

| Kk(кей) | [k] | Как звук (к) | kind – [kaɪnd] – (кайнд) – вид, род, разновидность |

| Ll(эл) | [l] | Как (л) | leg – [leɡ] – (лэг) – нога, ножка |

| Mm(эм) | [m] | Как (м) | man – [mæn] – (мэн) – мужчина |

| Nn(эн) | [n] | Как (н) | no – [nəʊ] – (ноу) – нет, не |

| Oo(оу) | [əʊ] | Похож на звук (оу) | most – [məʊst] – (моуст) – большинство, наибольший |

| [ɔː] | Долгий звук (о) | more – [mɔː] – (моː) – более, больше | |

| [ɒ] | Краткий звук (о) с оттенком (а). | not – [nɒt] – (нот) – не, нет | |

| [uː] | Долгий (у) без округления губ. | who – [huː] – (хуː) – кто | |

| [ʊ] | Похож на краткий (у) | good – [ɡʊd] – (гуд) – хороший, добрый | |

| [ʌ] | Напоминает невнятный краткий звук (а) | come – [kʌm] – (кам) – приходить, приехать | |

| [ɜː] | Похож на звук (ё) в словах мёд, лён. | work – [ˈwɜːk] – (уёːк) – работа | |

| Pp(пиː) | [p] | Похож на русский (п). | pen – [pen] – (пен) – ручка |

| Qq(кьюː) | [k] | Похож на русский (к). | headquarters – [hɛdˈkwɔːtəz] – (хэ´дкуотаз) – штаб, центр |

| Rr(aː) | [r] | Как русский (р) без вибрации. | red – [red] – (рэд) – красный |

| Ss(эс) | [s] | Похож на русский (с). | so – [ˈsəʊ] – (со´у) – так, таким образом |

| Tt(тиː) | [t] | Похож на русский (т). | tea – [tiː] – (тиː) – чай |

| Uu(юː) | [ʊ] | Похож на краткий (у) | put – [ˈpʊt] – (пут) – положить, класть, ставить |

| [ʌ] | Напоминает невнятный краткий звук (а) | cut – [kʌt] – (кат) – порез, разрез | |

| [juː] | Долгий (ю) | tune – [tjuːn] – (тьюːн) – мелодия, настроить, настраивать | |

| [ɪ] | Похож на русский (и) с небольшим оттенком (ы) и (э), как в слове снаружи | busy – [ˈbɪzi] – (би´зи) – занятой, занятый | |

| [ɜː] | Похож на звук (ё) в словах мёд, лён. | turn – [tɜːn] – (тёːн) – повернуть, поворачиваться | |

| Vv(виː) | [v] | Похоже на звук (в) | very – [ˈveri] – (вэ´ри) – очень, даже |

| Ww(даблъю) | [w] | Звук, похожий на (у) губы вытягиваются и округляются. | world – [wəːld] – (уо´ːлд) – мир |

| Xx(экс) | [ks] | похоже на звук (экс) | X-ray – [ˈeks.reɪ] – (э´ксрэй) – рентгеновский снимок, рентгеновский |

| [z] | похоже на русский звук (з) | Xerox – [ˈzɪə.rɒks] – (зи´рокс) – ксерокс | |

| Yy(уай) | [aɪ] | Как (ай) в слове май | by – [baɪ] – (бай) – по, на, к, при |

| [j] | Похож на слабый русский – (й) | yes – [jes] – (йес) – да, согласие | |

| [ɪ] | Похож на русский (и) с небольшим оттенком (ы) и (э), как в слове снаружи | duty – [ˈdjuːtɪ] – (дью´ːти) – обязанность, долг | |

| Zz(зэд) | [z] | Похож на русский (з). | zip – [zɪp] – (зип) – застёжка-молния |

- Дополнительно:

- Транскрипция

- Звуковая транскрипция

- Как пользоваться транскрипцией

- Расшифровка транскрипции.

- Распечатать транскрипцию

- Распечатать карточки с транскрипцией

Более подробно о том, что обозначает штрих, двоеточие, круглые скобки и другие символы.

Как пользоваться транскрипцией

Вы можете посмотреть другой вариант английской транскрипции и если это необходимо распечатать или скопировать для редактирования в «Microsoft Word»

Транскрипция английского языка

Произношение английских звуков.

Произношение английских гласных.

Произношение английских звуков представлено русскими буквами, вам следует понимать что передать правильное английское произношение используя русский алфавит не возможно.

- ɑː долгий, глубокий а

- ʌ краткий гласный а, как в русском слове бегать.

- ɒ = ɔ – краткий, открытый о

- ɔː – долгий о

- зː – долгий гласный ё, как в русском слове ежик.

- æ – открытый э

- e – как э в слове эти

- ə – неясный безударный звук, похож на э

- iː – долгий и

- ɪ – краткий, открытый и

- ʊ = u – краткий у, произносимый со слабым округлением губ.

- uː – долгий у произносимый без сильного округления губ.

Двугласные звуки

| eɪ – эй | ɔɪ – ой |

| əʋ – эу | ɪə – иа |

| аɪ – ай | еə – эа |

| аʋ – ау | ʋə – уа |

Произношение английских согласных.

- p – п

- b – б

- m – м

- f – ф

- v – в

- s – с

- z – з

- t – напоминает русский звук т, произнесенный при положении языка у десен.

- d – напоминает русский звук д, произнесенный при положении языка у десен.

- n – напоминает русский звук н, произнесенный при положении языка у десен.

- l – напоминает русский звук л, произнесенный при положении языка у десен.

- r – очень твердый звук, произносимый без вибрации языка. Соответствует звуку р в слове жребий

- ʃ – мягкий русский ш

- ʒ – мягкий русский ж, как в слове дрожжи.

- tʃ – ч

- ʤ – похож на русский звук дж (озвонченный ч)

- k – к

- h – вдох, напоминающий слабо произнесенный звук х

- ju – долгое ю в слове южный

- je – звук е в слове ель

- jɔ – звук ё в слове ёлка

- jʌ – звук я в слове яма

- j – напоминает русский звук й перед гласными звуками. Встречается в сочетании с гласными.

Английские согласные звуки не имеющие приблизительных соответствий в русском языкеː

- w – образуется при помощи округленных губ (как при свисте). Похоже на звук в произнесенный одними губами. В переводе обозначается буквами в или уː Williams – Уильямс, Вильямс.

- ƞ – Приоткройте рот и произнесите н, не закрывая рта.

- ɵ – Выдвиньте немного распластанный кончик языка между зубами и произнесите русское с

- ð – Выдвиньте немного распластанный кончик языка между зубами и произнесите русское з

Укажите верное соответствие

[ei] – эй,ей

[æ] – э

[æ] – яз

[ɑ:] – а:

[ɔ:] – о:

[ɔ:] – эсз

[ɔ] – о

[b] – б

[k] – к

[ ʃ ] – ш

[ai] – ай

[ʤ] – дж

[ou] – оу

[ɔ:] – о:

[u:] – у:

[ʌ ] – а

[ə:] – э:

[ə:] – ё

[ju:] – ю:

Русско английский аудио разговорник

- Русско английский разговорник.

Главная страница.

Главная страница. - Обиходные выражения на английском.

- Общение на английском.

- О себе на английском.

- Русско английский разговорник. Произношение.

- Транскрипция. Английские звуки.

Английские слова русскими буквами

- Английские слова русскими буквами. Главная страница.

- Урок 1. Обиходные выражения.

- Урок 2. Знакомство.

- Урок 3. Возраст, семья.

- Урок 4. Язык.

Alphabet GAN: ИИ генерирует английский алфавит! | Суджан Датта

Вот как я создал GAN, которая может генерировать английские алфавиты.

Эволюция вывода GAN на протяжении эпох Во-первых, вам нужно знать, что такое GAN на самом деле. Ну вот краткое описание. Генеративно-состязательная сеть представляет собой комбинацию двух моделей, а именно Генератора и Дискриминатора. Генератор пытается создать поддельные данные, имитирующие исходные данные. С другой стороны, Дискриминатор пытается определить, являются ли данные оригинальными или поддельными. Благодаря состязательной настройке обе модели в конечном итоге продолжают лучше справляться со своими задачами. Конечно, о GAN нужно понимать гораздо больше. Пожалуйста, посмотрите это видео, если вам интересно…

Благодаря состязательной настройке обе модели в конечном итоге продолжают лучше справляться со своими задачами. Конечно, о GAN нужно понимать гораздо больше. Пожалуйста, посмотрите это видео, если вам интересно…

В этой статье я хочу показать вам, как реализовать одну такую GAN. Я также упомяну целую кучу советов, которые помогут вам в обучении вашей первой ГАН. Но прежде чем перейти к модели, давайте разберемся с набором данных.

Здесь я использую набор данных рукописного английского алфавита в стиле MNIST. Набор данных AZ содержит 372 450 символов из 26 классов. Каждая выборка данных представляет собой изображение алфавита в оттенках серого. Как и в наборе данных MNIST, размер каждого изображения равен 28px*28px и представлен как 784 ( 28*28 ) размерный вектор. Давайте визуализируем некоторые из них…

100 случайных изображений из набора данных EMNIST Letters Первоначально значения пикселей находились в диапазоне [0, 255] , но мы должны нормализовать их перед подачей в любую модель машинного обучения. Как правило, мы нормализуем пиксели между [0, 1] путем деления 255,0 , но здесь мы нормализуем их между [-1, 1] . Это связано с тем, что позже мы будем использовать функцию tanh (диапазон tanh = [-1, 1] ).

Как правило, мы нормализуем пиксели между [0, 1] путем деления 255,0 , но здесь мы нормализуем их между [-1, 1] . Это связано с тем, что позже мы будем использовать функцию tanh (диапазон tanh = [-1, 1] ).

Теперь давайте построим нашу GAN. Мне нравится делать это за 4 шагов.

Генератор представляет собой нейронную сеть, которая принимает вектор шума ( 100 -мерный) в качестве входных данных и выдает изображение одного английского алфавита. Поскольку мы работаем с данными изображения, имеет смысл использовать сверточную нейронную сеть. Идея состоит в том, чтобы увеличивать пространственные размеры входных данных по мере их прохождения через разные слои, пока они не приобретут желаемую выходную форму (9).0011 28px*28px ). Первые два слоя сети являются плотными слоями с активацией ReLu. Я настоятельно рекомендую использовать BatchNormalization на выходе каждого слоя.

Я настоятельно рекомендую использовать BatchNormalization на выходе каждого слоя.

Примечание. Пакетная нормализация ускоряет сходимость обучения. Намного быстрее.

Обратите внимание, что первый плотный слой содержит 1024 нейронов, а второй содержит 6272 нейронов. После этого идет слой Reshape. Изменение формы важно, потому что мы хотим использовать свертку впоследствии, а для применения свертки нам нужны матричные объекты, а не векторы столбцов/строк.

Примечание. Чтобы найти правильные размеры, нам нужно подумать в обратном направлении! Сначала определите размеры матриц ( 7*7 ) и сколько ( 128 ) из них вы хотите, затем умножьте их, чтобы получить размер ( 7*7*128 = 6272 ) плотного слоя.

Перед применением свертки мы проведем апсемплинг матриц. Я использовал ( 2, 2 ) повышающую дискретизацию, которая увеличит размерность с 7*7 до 14*14 .

UpSampling — это функция, обратная функции объединения.

После этого у нас есть сверточные фильтры 2*2 ( 64 ). Обратите внимание, что я инициализировал веса ядер согласно нормальному распределению. Активация для этого слоя — LeakyReLu. Затем снова у нас есть слой повышающей дискретизации, за которым следует слой свертки. На этот раз слой UpSampling выведет 28*28 размерные матрицы. Последний слой свертки содержит только фильтр 1 , потому что нам нужен только один канал для нашего изображения в градациях серого. Функция активации здесь tanh . По этой причине мы нормализовали значения пикселей между [-1, 1] .

Примечание. Мы могли бы избежать слоев UpSampling, используя транспонированные свертки. Потому что они также могут увеличивать размеры матрицы.

Код:

ГенераторАрхитектура:

Модель: "sequential_1"

_________________________________________________________________

Слой (тип) Output Shape Param #

========================== ========================================

dens_1 (Dense) (Нет, 1024) 103424

________________________________________________________________

batch_normalization_1 (Пакетный (Нет, 1024) 4096

_________________________________________________________________

активация_1 (Активация) (Нет, 1024) 0

_________________________________________________________________

плотности_2 (Плотная) (Нет, 6272) 6428800

_________________________________________________________________

batch_normalization_2 (Пакетный (Нет, 6272) _________________________________ 251088 9 9 9 9 9

activation_2 (Activation) (None, 6272) 0

_________________________________________________________________

reshape_1 (Reshape) (None, 7, 7, 128) 0

_________________________________________________________________

up_sampling2d_1 (UpSampling2 (None, 14, 14, 128) 0

_________________________________________________________________

conv2d_1 (Conv2D ) (Нет, 14, 14, 64) 32832

_________________________________________________________________

batch_normalization_3 (Batch (None, 14, 14, 64) 256

_________________________________________________________________

leaky_re_lu_1 (LeakyReLU) (None, 14, 14, 64) 0

_________________________________________________________________

up_sampling2d_2 (UpSampling2 (None, 28, 28, 64) 0

_________________________________________________________________

conv2d_2 (Conv2D) (Нет, 28, 28, 1) 577

================================= ==============================

Всего параметров: 6 595 073

Обучаемых параметров: 6 580 353

Необучаемых параметров: 14 720

_________________________________________________________________

Вы заметили, что здесь я не скомпилировал генератор? Это будет сделано на шаге 3rd .

Наш дискриминатор — это просто двоичный классификатор, который принимает изображение в градациях серого в качестве входных данных и предсказывает, является ли оно оригинальным изображением или поддельным, т. е. созданным генератором. Первые два слоя являются слоями свертки. Обратите внимание, что я использовал шаг 2 , что означает, что выходное измерение будет меньше входного. Итак, нам не нужны объединяющие слои. Размер фильтра составляет 5*5 для обоих слоев, но количество фильтров во втором слое больше.

Примечание. При создании дискриминатора вы должны помнить, что наша цель — отдать предпочтение генератору, потому что мы хотим генерировать поддельные изображения. Следовательно, сделайте дискриминатор немного слабее генератора. Например, здесь я использовал меньше слоев свертки в дискриминаторе.

После слоев свертки нам нужно сгладить вывод, чтобы мы могли передать его на плотный слой. Размер плотного слоя составляет 256 с отсевом 50% . Наконец, у нас есть сигмовидный слой, как и любой другой двоичный классификатор. Теперь нам нужно скомпилировать дискриминатор. Потеря должна быть двоичной кросс-энтропией, и я использовал собственный оптимизатор Адама (скорость обучения = 0,0002 ).

Размер плотного слоя составляет 256 с отсевом 50% . Наконец, у нас есть сигмовидный слой, как и любой другой двоичный классификатор. Теперь нам нужно скомпилировать дискриминатор. Потеря должна быть двоичной кросс-энтропией, и я использовал собственный оптимизатор Адама (скорость обучения = 0,0002 ).

Примечание. Скорость обучения Адама по умолчанию ( 0.001 ) слишком велико для GAN, поэтому всегда настраивайте оптимизатор Adam.

Код:

ДискриминаторАрхитектура:

Модель: "sequential_2"

_________________________________________________________________

Слой (тип) Выходная форма Парам #

==================== ============================================

conv2d_3 (Conv2D) (Нет, 14, 14, 64) 1664

________________________________________________________________

leaky_re_lu_2 (LeakyReLU) (Нет, 14, 14, 64) 0

_________________________________________________________________

conv2d_4 (Conv2D) (Нет, 5, 5, 128) 204928

_________________________________________________________________

leaky_re_lu_2 (LeakyReLU) 51, 5, 5, 18 (Нет) _________________________________________________________________

flatten_1 (Сведение) (Нет, 3200) 0

_________________________________________________________________

плотности_3 (Dense) (Нет, 256) 819456

_________________________________________________________________

Leaky_re_lu_4 (LeakyReLU) (Нет, 256) 0

_________________________________________________________________

dropout_1 (Выпадение) (Нет, 256) _________________________________________________ 1 9

0151 плотности_4 (Плотные) (Нет, 1) 257

===================================== ==========================

Всего параметров: 1 026 305

Обучаемых параметров: 1 026 305

Необучаемых параметров: 0

_________________________________________________________________

Согласно исходной статье GAN, мы должны обучать генератор и дискриминатор отдельно. Тогда зачем этот шаг?

Тогда зачем этот шаг?

Дискриминатор можно обучить напрямую путем обратного распространения потерь, вычисленных на последнем сигмовидном слое. Но для обучения генератора нам нужно отправить эту потерю обратно в генератор, не влияя на веса дискриминатора!

Один из способов добиться этого — создать новую модель путем объединения генератора и дискриминатора. И именно поэтому я не скомпилировал генератор раньше. Назовем новую модель ган . Он принимает вектор шума в качестве входных данных, а затем пропускает его через генератор для создания поддельного изображения. Затем изображение проходит через дискриминатор, который вычисляет вероятность того, что это исходное изображение. Когда мы будем тренировать этот ган, дискриминатор не должен ничему учиться. Следовательно, ‘дискриминатор.обучаемый = ложь’. Будут изменены только веса генератора.

Код:

генератор + дискриминатор = ganАрхитектура:

Модель: "model_1"

_________________________________________________________________

Слой (тип) Параметр формы вывода #

================== ==============================================

input_1 ( InputLayer) (Нет, 100) 0

_________________________________________________________________

последовательный_1 (Последовательный) (Нет, 28, 28, 1) 6595073

_________________________________________________________________

последовательный_2 (Последовательный) (Нет, 1) 1026305

=================== =============================================

Всего параметров: 7 621 378

Обучаемые параметры: 6 580 353

Необучаемые параметры: 1 041 025

_________________________________________________________________

Наконец-то мы готовы тренировать нашу ГАН! Код кажется вам странным? Не волнуйтесь, я объясню каждый шаг.

Код:

Тренировочный цикл для GANВнешний для прохождения эпох, внутренний для пакетов. Я обучил модели для 80 эпох, а размер_пакета равен 128. Итак, за одну эпоху у нас будет 2909 (steps_per_epoch = ⌊ количество выборок данных/размер_пакета⌋ = ⌊372 450/128⌋ = 2909) шагов.

Поезд D при фиксированном G:

Во-первых, число векторов шума batch_size формируется путем случайного извлечения чисел из стандартного нормального распределения. Затем эти векторы передаются генератору для создания поддельных изображений. Теперь мы извлекаем количество реальных изображений batch_size из обучающих данных. Чтобы получить входные данные для дискриминатора, нам нужно объединить поддельные и настоящие данные. Соответственно, нам нужно упомянуть вектор метки (0: поддельные данные, 1: настоящие данные). Но подождите, код говорит 0,1 и 0,9вместо! ВТХ происходит?

Этот метод называется сглаживанием уровней. Это не позволяет дискриминатору быть слишком уверенным в своем прогнозе.

Затем мы вызываем функцию train_on_batch для дискриминатора и передаем пары меток данных.

Поезд D при фиксированном G:

Здесь нам нужны только векторы шума и метки. Вектор метки содержит единицы. Подождите, генератор создает фальшивые данные, поэтому метки не должны быть 0?

Да. Но здесь мы намеренно даем неправильные ярлыки, чтобы дискриминатор ошибался. Причина в том, что мы хотим, чтобы генератор превзошел дискриминатор. Делая это, G будет знать, как ведет себя D, когда ему даются настоящие метки, и он (G) изменит свои веса соответственно, чтобы обмануть D. Помните, что на этом этапе мы не меняем веса дискриминатора, поэтому дискриминатор не ‘ разучиться чему-либо.

Теперь мы вызываем функцию train_on_batch для генератора и передаем пары меток данных. И вот друзья, как тренируется ГАН!

Позвольте мне показать вам некоторые из лучших (выбранных вручную) результатов, которые дала моя модель…

Сгенерированные ИИ алфавиты (T, P, J, S, A, E, L, U) Вот полный код этот проект. Вуаля! Теперь вы знаете, как тренировать ГАН!

Вуаля! Теперь вы знаете, как тренировать ГАН!

Если вы хотите узнать больше, посмотрите это…

ИИ генерирует алфавиты для двух языков (английский и бенгальский)Надеюсь, вам понравилось чтение. До следующего раза… Приятного обучения!

Английские буквы ai векторов скачать бесплатно графика

Английские буквы ai векторов скачать бесплатно новую коллекцию Расширенный поиск Запросить дизайн

[ Векторы ] w алфавит обучающий шаблон кит арбуз ветряная мельница эскиз ( ai , eps 2.75MB )

All-free-download.com

[ Векторы ] piwi kao pk буквенные логотипы изолированные стилизованные тексты наброски ( .ai .eps .svg 1.30MB )

Все-бесплатно-download.com

[ Векторы ] найти недостающую букву образование шаблон собака эскиз тексты пустой декор ( . ai .eps .svg 930.52KB )

ai .eps .svg 930.52KB )

All-free-download.com

[ Векторы ] найти недостающую букву образование шаблон смешной крокодил животные тексты пустой эскиз ( .ai .eps .svg 989.68KB )

All-free-download.com

[ Векторы ] шаблон логотипа форекс бык медведь голова плоский заглавные буквы декор ( .ai .eps .svg 2.57MB )

All-free-download.com

английский английский ai английские буквы буквы ai английский язык английский шрифт ai вектор письмо английская школа английская буква английский графика английский вектор язык английский английский искусство иллюстрация английская буква ai старые английские буквы

[ Векторы ] английский послеобеденный чай рекламный баннер чайник и чашка плоский эскиз ( . ai .eps .svg 2.76MB )

ai .eps .svg 2.76MB )

Все-бесплатно-download.com

[ Векторы ] найти пропавшую букву образования шаблон льва тексты эскиз ( .ai .eps .svg 1.00MB )

All-free-download.com

[ Векторы ] найти недостающую букву образовательный шаблон бегемот животных тексты пустой эскиз ( .ai .eps .svg 906.55KB )

All-free-download.com

[ Векторы ] найти недостающую букву образовательный шаблон милый нарисованный от руки текст котенка пустой эскиз ( .ai .eps .svg 1.31MB )

Все-бесплатно-download.com

[ Векторы ] цветок любовное письмо значок элегантный классический декор ( . ai .eps .svg 2.15MB )

ai .eps .svg 2.15MB )

All-free-download.com

[ Векторы ] английский чайный сервиз баннер плакат элегантный классический плоский эскиз ( .ai .eps .svg 3.29MB )

All-free-download.com

[ Векторы ] найти пропавшую букву образовательный шаблон плоский мультфильм акула тексты пустой декор ( .ai .eps .svg 892,92 КБ)

All-free-download.com

[ Векторы ] найти недостающую букву образование шаблон милый слон тексты пустой эскиз ( .ai .eps .svg 1,007.26KB )

All-free-download.com

[ Векторы ] найти недостающую букву образование шаблон милый осьминог тексты пустой эскиз ( . ai .eps .svg 930.14KB )

ai .eps .svg 930.14KB )

All-free-download.com

[ Векторы ] дорогая дорогая любовное письмо с пером валентинка значок ретро дизайн ( .ai .eps .svg 2.08MB )

All-free-download.com

[ Векторы ] piwi kao pk letter logo template современный элегантный стилизованный текстовый эскиз ( .ai .eps .svg 1.34MB )

All-free-download.com

[ Векторы ] найти пропавшую букву образовательный шаблон смешной бабуин животных тексты пустой эскиз ( .ai .eps .svg 1,006.88KB )

Все-бесплатно-download.com

[ Векторы ] найти недостающую букву образовательный шаблон тигр наброски тексты пустой эскиз ( . ai .eps .svg 1.33MB )

ai .eps .svg 1.33MB )

All-free-download.com

[ Векторы ] любовное письмо с иконкой пера плоский ретро эскиз ( .ai .eps .svg 1.65MB )

All-free-download.com

[ Векторы ] форекс логотип плоские заглавные буквы свечи элементы декора ( .ai .eps .svg 1.62MB )

Все-бесплатно-download.com

[ Векторы ] piwi kao pk letter logo templates современный плоский геометрический стилизованный текст эскиз ( .ai .eps .svg 1.38MB )

All-free-download.com

[ Векторы ] найти недостающую букву образование шаблон плоский мультфильм жираф тексты пустой декор ( . ai .eps .svg 1.08MB )

ai .eps .svg 1.08MB )

All-free-download.com

[ Векторы ] найти недостающую букву образовательный шаблон носорог тексты животных пустой контур ( .ai .eps .svg 941.50KB )

All-free-download.com

[ Векторы ] forex logo template заглавные буквы стрелки декор ( .ai .eps .svg 827.80KB )

All-free-download.com

[ Векторы ] значок любовного письма элегантный классический ручной штамп цветы декор ( .ai .eps .svg 12.05MB )

Все-бесплатно-download.com

Загрузка дополнительных элементов, пожалуйста, подождите.